Создание Robots.txt — Работа с поисковыми системами.

Мы начали с вами писать статьи, так же писать статьи оптимизированные под поисковые системы, создали собственную RSS ленту, теперь настало время создать robots.txt для WordPress. Для чего он нужен? Также в конце статьи вы сможете скачать правильный robots.txt для WordPress.

Для чего нужен файл robots.txt ?

Зачем нужен файл robots.txt? Пример №1:

Но не смотря на это, для поисковых систем wpmen.ru и www.wpmen.ru это 2 совершенно разных сайта. И представьте, что о вас подумает например Yandex, если увидит 2 абсолютно идентичных сайта, прям все точь — в точь…

Запрет страниц в robots.txt Пример №2:

В свою очередь поисковые системы сильно занижали главную страницу в выдаче, регламентируя это дублированием контента. Иногда даже попадались фильтры, если веб-мастер долго не реагировал на эту ошибку. К счастью сейчас эта проблема встречается редко, потому что современные шаблоны самостоятельно исправляют эту проблему.

Правильный robots.txt, пример:

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tagUser-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: wpnew.ru

Sitemap: http://wpmen.ru/sitemap.xml.gz

Sitemap: http://wpmen.ru/sitemap.xml

Давайте немного разберем что к чему: User-agent — это критерий для ввода поисковой системы. Если вы хотите ввести данные абсолютно для всех поисковых систем, то нужно ввести: User-agent: * Звездочка в свою очередь снимает все ограничения и само собой вводит эти правила для всех поисковых систем.

Если вы хотите указать данные для какой-то конкретной поисковой системы, то за место звездочки нужно написать название поисковой системы. Например: User-agent: Yandex . Не все так просто, каждый поисковик имеет своего бота, который также называется по разному, вот основные из них:

Google (google.com) — Googlebot;

Yandex (yandex.ru) — Yandex;

Рамблер (rambler.ru) — StackRambler;

Mail (mail.ru) — Mail.Ru;

Yahoo! и AOL (yahoo.com и aol.com) — Slurp;

Bing (bing.com) — MSNBot;

Alexa (alexa.com) — ia_archiver;

Ask (ask.com) — Teoma;

К сожалению это еще не весь список поисковых ботов. Многие поисковые системы имеют несколько поисковых ботов, с несколькими именами. Например у Яндекса есть обычный поисковый бот, бот по зеркалам, бот по картинкам, видеозаписям и так далее. Полный список ботов вы сможете найти на специализированном сайте о Robots.txt.

Примеры с разбором правильного файла robots.txt:

- «Allow: » — разрешает индексацию файлов или страниц указанных после двоеточия.

- «Disallow: » — запрещающий индексацию директив, но, если после двоеточия оставить пустое место, то он разрешает индексацию всего сайта.

- «Disallow: / » — полностью запрещает поисковым системам добавлять в индекс страницы сайта.

- «Disallow: /picture/ » — Запрещает добавлять в индекс, а так же просматривать папку /picture/ и все последующие каталоги, которые входят в него.

- «Disallow: /picture » — Заперт просмотра каталога /picture, а так же всех файлов, папок и так далее, которые имеют в своем названии слово picture ( /pictures, /picture11, /picture.jpg, /picture.htm и т.д).

- «Disallow: *.php » — запрет просмотра всех файлов формата PHP.

Скачать готовый файл robots.txt для WordPress:

Скачать Robots.txt для WordPress Бесплатно.

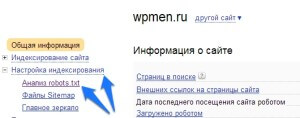

Проверка Robots.txt с помощью Яндекса:

Также специально для поисковых систем предлагаю вам прочитать статью о том, как создать карту сайта для поисковых систем. Данный урок так же поможет вам в развитии вашего сайта среди поисковых систем *cool*

На этом все дорогие друзья, не пропустите следующие, еще более интересные и полезные уроки, подписывайтесь на бесплатную рассылку уроков 😉 Всего вам наилучшего, до скорых встреч

Добавить комментарий